一文看懂存算一体布局全景图:初创公司正另辟蹊径

(图片来源:海洛)

文/Renee

编辑/孙越

2023年,算力正被CHATGPT推上数字时代的宝座。

在今年第十七届中国IDC产业年度大典上,各路大佬们都在围绕“算力”,展开自己的畅想:

(何宝宏演讲内容 图源:IDC产业年度大典演讲PPT)

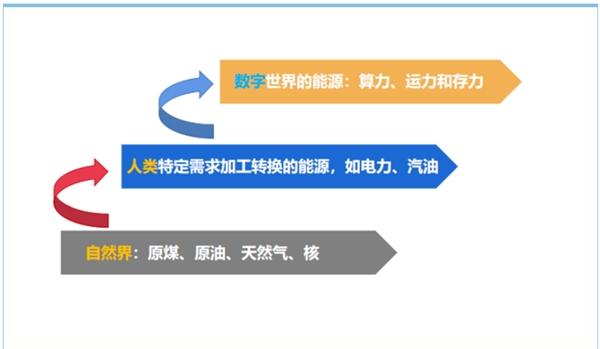

中国信通院云计算与大数据研究所所长何宝宏表示,数字世界消耗最核心的能源是算力,算力是今天的“三次能源”。

称算力是“三次能源”,一是因为算力是通过各种芯片、软件等数字技术,从二次能源电力加工转换而来;二是因为,算力与电力一样有着举足轻重的地位:电力网络是一个国家工业化的基础,算力网络是一个国家数字化的基础。

各路大佬除了对算力提出畅想,也给出了实际规划路线:在大会上,商汤科技、鹏博士大数据、浩云长盛、超聚变、竹间智能等业内专业人士表示,未来数据中心将分化成两种类型:追求极致算力的数据中心与产业赋能型的数据中心。

据介绍,追求极致算力的数据中心旨在提供最大的计算能力,以满足越来越庞大的AI模型的训练需求。这类数据中心主要关注计算能力和效率,目标是实现极高的性能和运算速度,通常会采用最先进的硬件设备,如高性能处理器、GPU和高速内存。

“极致”二字,全然显示着,算力正成为“紧俏货”,需要快马加鞭去布局。这,也是目前的现状:除了“东数西算”工程的启动,国家以及科技企业正加紧对液冷、水下数据中心、量子计算的实践与探索,企图补上算力的“窟窿”。

而当前,最热门的解决方案,莫过于“存算一体”。

存算一体(Computing in Memory),就是在存储器中嵌入计算能力,以新的运算架构进行二维和三维矩阵乘法/加法运算。与以往的冯诺依曼架构相比,其打破了由于计算单元与存储单元过于独立而导致的“存储墙”,能够达到用更低功耗实现更高算力的效果。

自2022年开始,芯片领域“天降紫微星”,存算一体实打实地火了:

学界,ISSCC上存算/近存算相关的文章数量迅速增加:从20年的6篇上涨到23年的19篇;其中数字存内计算,从21年被首次提出后,22年迅速增加到4篇。

产界,巨头纷纷布局存算一体,国内陆陆续续也有近十几家初创公司押注该架构:

在特斯拉2023 Investor Day预告片末尾,特斯拉的do#xad;jo超算中心和存算一体芯片相继亮相;

在更早之前,三星、阿里达摩院包括AMD也早早布局并推出相关产品,且“用过的都说好”:

阿里达摩院表示,相比传统CPU计算系统,存算一体芯片的性能提升10倍以上,能效提升超过300倍;

三星表示,与仅配备HBM的GPU加速器相比,配备HBM-PIM的GPU加速器一年的能耗降低了约2100GWh。

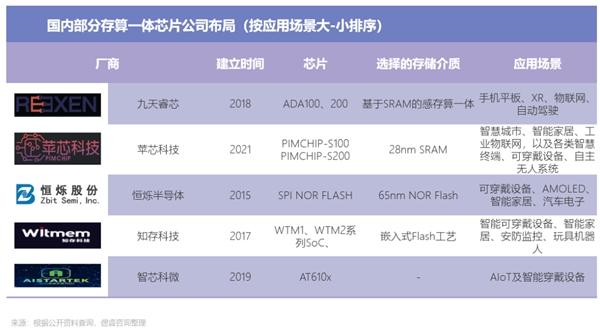

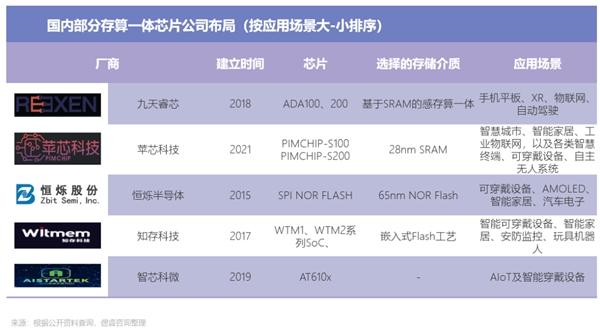

目前,国内的亿铸科技、知存科技、苹芯科技、九天睿芯等十余家初创公司采用存算一体架构投注于AI算力,其中亿铸科技专注AI大算力。

同时,我们可以看到,各个初创公司选择了不同的存储介质:RRAM、SRAM、闪存等,且各家公司芯片适用的场景也有所区别。

本文,祁6床旖崂砉谕庖丫氤〉目萍计笠担酝济杌嬉环嫠阋惶迦巴肌

01存算一体的“兄弟姐妹”

一时间,学术界、产业界纷纷向存算一体抛去橄榄枝,而大家所青睐的存算一体,大不相同。

学术界和产业界对存算一体的技术路径尚未形成统一的分类,目前主流的划分方法是依照计算单元与存储单元的距离,将其大致分为近存计算(PNM)、存内处理(PIM)、存内计算(CIM)。

近存计算(PNM)

近存计算,本质上仍是存算分离架构,计算操作仍由位于存储外部、独立的计算单元完成。只不过,该构架能够通过存储上移或计算的方式,让数据靠近计算单元,从而缩小数据移动的延迟和功耗。

特斯拉、阿里达摩院、三星等大厂所选择的,便是近存计算。

据Dojo项目负责人Ganesh Venkataramanan介绍,特斯拉Dojo(AI训练计算机)所用的D1芯片相比于业内其他芯片,同成本下性能提升4倍,同能耗下性能提高1.3倍,占用空间节省5倍。

具体来说,在D1训练模块方面,每个D1训练模块由5x5的D1芯片阵列排布而成,以二维Mesh结构互连。片上跨内核SRAM达到惊人的11GB,由于用上近存计算架构,能效比为0.6TFLOPS/W@BF16/CFP8。业内人士表示,对于CPU架构来说,这一能效比非常不错。

阿里达摩院在2021年发布采用混合键合(Hybrid Bonding)的3D堆叠技术――将计算芯片和存储芯片face-to-face地用特定金属材质和工艺进行互联。在实际推荐系统应用中,相比传统CPU计算系统,存算一体芯片的性能提升10倍以上,能效提升超过300倍。

三星基于存内处理架构,发布存储器产品HBM-PIM(严格意义上是PNM)。三星表示该架构实现了更高性能与更低能耗:与其他没有HBM-PIM芯片的GPU加速器相比,HBM-PIM芯片将AMD GPU加速卡的性能提高了一倍,能耗平均降低了约50%。与仅配备HBM的GPU加速器相比,配备HBM-PIM的GPU加速器一年的能耗降低了约2100GWh。

存内处理(PIM)

存内处理,本质上同样是存算分离,不过相较于近存计算,“存”与“算”距离更近:独立的计算单元内嵌于存储芯片,同样也是各干各的。

国内知存科技选择的便是存内处理:2022年3月,知存科技量产的基于PIM的SoC芯片WTM2101正式投入市场。距今未满1年,WTM2101已成功在端侧实现商用,提供语音、视频等AI处理方案并帮助产品实现10倍以上的能效提升。

存内计算(CIM)

存内计算,才是真正的、狭义的存算一体。在该框架下,存储单元和计算单元完全融合,没有独立的计算单元:直接在存储器颗粒上嵌入算法,由存储器芯片内部的存储单元完成计算操作。

这,也就是国内大部分初创公司所说的存算一体:

亿铸科技,基于CIM框架、RRAM存储介质的研发“全数字存算一体”大算力芯片,通过减少数据搬运提高运算能效比,同时利用数字存算一体方法保证运算精度,适用于云端AI推理和边缘计算。智芯科微,于2022年底推出业界首款基于SRAM CIM的边缘侧AI增强图像处理器。

并且存内计算,正一步步提高声量:在ISSCC 2023的34个session中,有3个session的标题都直接用到存内计算。

可以看到,大公司与初创公司“自觉”分为两个阵营:特斯拉、三星、阿里巴巴等拥有丰富生态的大厂以及英特尔,IBM等传统的芯片大厂,几乎都在布局PNM;而知存科技、亿铸科技、智芯科等初创公司,在押注PIM、CIM等“存”与“算”更亲密的存算一体技术路线。

综合生态大厂思量的是,如何快速攻破算力和功耗的瓶颈,让自己丰富的应用场景快速落地;芯片大厂们针对客户所提出的高效算力和低功耗需求,开发出符合客户需求的技术。

也就是说,大厂对存算一体架构提出的需求是“实用、落地快”,而近存计算作为最接近工程落地的技术,成为大厂们的首选。

而中国初创公司们,由于成立时间较短、技术储备薄弱:缺乏先进2.5D和3D封装产能和技术,为打破美国的科技垄断,中国初创企业聚焦的是无需考虑先进制程技术的CIM。

02“新老”器件,硝烟四起

从目前发展路径来看,存算一体芯片正处于多种存储介质百花齐放的格局,存算一体架构正承载着多种存储介质:

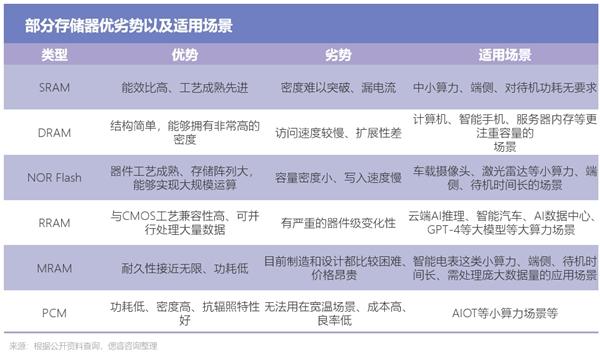

传统存储器阵营,易失性存储器包括SRAM、DRAM、非易失性存储器包括NAND、NOR等,新型存储器包括RRAM、MRAM等。同时,不同介质使用的应用场景也大不相同。

目前,在传统存储器阵营中,SRAM、DRAM、NOR Flash出现的频次更高。

SRAM

一种静态随机存储器,原理是利用晶体管是否接通来代表一个bit是1还是0,有着以下特性:

基于速度快、成熟度高、密度难以突破的特性,SRAM一直广受欢迎:

在学术领域,SRAM凭借其高成熟度和高存取速度成为存算一体领域里的热门研究对象;

在市场应用方面,SRAM作为传统存储介质适合IP化,SRAM存算一体在中小算力、端侧、对待机功耗无要求的场景,例如可穿戴设备、无人车等市场具有一定的应用价值:

九天睿芯,基于神经拟态感存算一体架构的芯片已实现量产,应用于智能语音和视觉识别领域。

苹芯科技,开发实现多款基于SRAM的存内计算加速单元并实现流片,目前处于外部测试和demo阶段,产品应用于图像识别、无人机等领域。

DRAM

一种动态随机存取存储器,原理是利用电容内存储电荷的多寡来代表一个bit是1还是0。该存储器有着以下特性:

基于容量大、成本低、功耗大等特性,DRAM常用于更注重容量的主存储器,如计算机、智能手机、服务器内存等。

NOR Flash

一种非易失闪存技术,利用存储单元的多值特性,通过器件本征的物理电气行为(例如基尔霍夫定律与欧姆定律)来实现多值MAC 运算。该存储器有着以下特性:

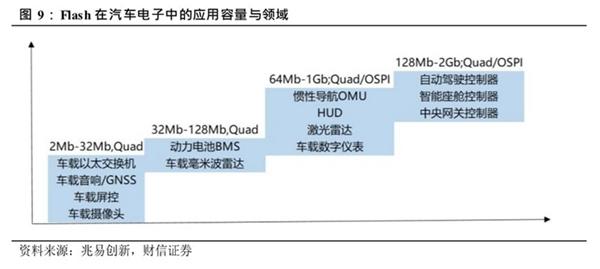

基于低功耗、容量小等特性,NOR FLASH更适用于车载摄像头、激光雷达等应用场景:

(Flash 在汽车电子中的应用容量与领域 图源:财信证券)

而在新型存储器中,RRAM、MRAM、PCM活跃度更高。

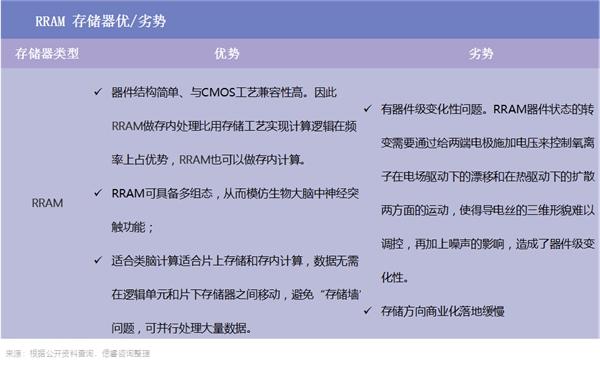

RRAM(ReRAM)

一种以非导性材料的电阻在外加电场作用下,在高阻态和低阻态之间实现可逆转换为基础的非易失性存储器。该存储器有着以下特性:

目前,RRAM工艺正一步步成熟:在2021年,晶圆代工厂台积电现身,为RRAM站台:宣布40nmRRAM进入量产,28nm和22nmRRAM准备量产。

国内同样传来利好消息:2022年2月,昕原半导体主导建设的RRAM 12寸中试生产线顺利完成了自主研发装备的装机验收工作,实现中试线工艺流程的通线,并成功流片(试生产)。

在工艺渐趋成熟背景下,基于兼容性高、微缩性好等特性,RRAM更适用于以下场景:

云端AI推理和边缘计算。亿铸科技基于RRAM研发的“全数字存算一体”大算力芯片,通过减少数据搬运提高运算能效比,同时利用数字存算一体方法保证运算精度,适用于云端AI推理和边缘计算。智能汽车。据云岫资本表示,RRAM不仅满足高读写速度和存储密度的要求,同时延迟可降低1000倍,可满足未来智能驾驶高实时数据吞吐量。安全性方面,RRAM具备宽温和可靠性。未来有望出现高性能、高集成度、高稳定性和低功耗的车规RRAM存储器。AI数据中心。RRAM相较NAND可提升100倍的读写性能,同时保持更低的功耗和高存储密度,有望解决未来数据中心高能效比,低延迟的需求,实现更高性能的AI数据中心。GPT-4等大模型。RRAM基于高密度存储,工艺兼容带来的性能优势,能够实现更低功耗、更高性能,缓解目前的算力压力。MRAM

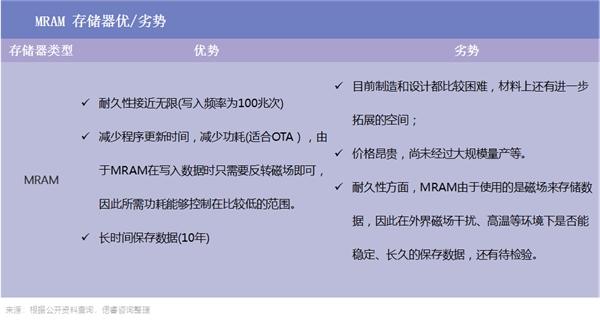

是一种基于隧穿磁阻效应的技术。该技术的工作原理是使用隧道层的“巨磁阻效应”来读取位单元,当该层两侧的磁性方向一致时为低电阻,当磁性方向相反时,电阻会变得很高。该存储器有以下特性:

基于耐久性高、低功耗等特性,MRAM有以下合适的应用领域:

适用于消耗大量计算资源的神经网络计算。智能电表等长时间、庞大数据量的应用场景,它能满足对高耐久性和快速写入速度的需求。PCM

PCM的原理是通过改变温度,让相变材料在低电阻结晶(导电)状态与高电阻非结晶(非导电)状态间转换。该存储器有以下特性:

基于抗辐射性好但成本、良率低等特性,根据我国拥有PCM相变存储器生产能力的集成电路IDM企业时代全芯官网显示,PCM有以下应用领域:

人工智能运算;PCM为基础的TCAM具有占地面积小,功耗低的优点。AIOT;将智能存储器应用与IoT的传感器上,可以有效的分担传感器对网络和云计算的负荷,从而进一步拓展物联网的功能。

综合来讲,存储介质各有各的优点,也各有各的“舒适圈”:

“新老”器件全面开花,皆有自己擅长的领域,但对于玩家来说,选择受限:传统存储市场已被垄断。

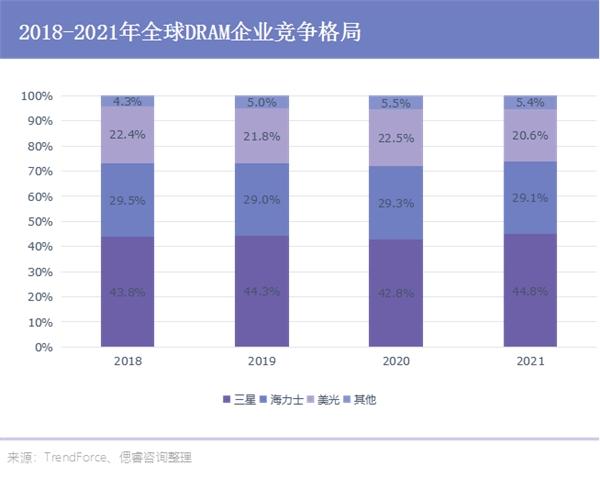

内存行业,美光、三星和SK Hynix在高性能存储领域市占率达100%;高性能计算领域,英特尔、AMD和英伟达的市场占有率也接近100%。高性能芯片代工领域,则被台积电和三星联合垄断。

例如DRAM,因极高的技术和资金壁垒,DRAM领域市场处于高度集中甚至垄断态势。目前,DRAM芯片市场是由三星、SK海力士和美光统治:2018至2020年,三大巨头市场占有率合计在95%左右。

基于此,初创企业正另辟蹊径:要么基于传统存储介质的存算一体制定特定场景的芯片;要么在存算一体架构下,用新型存储器,打破垄断。

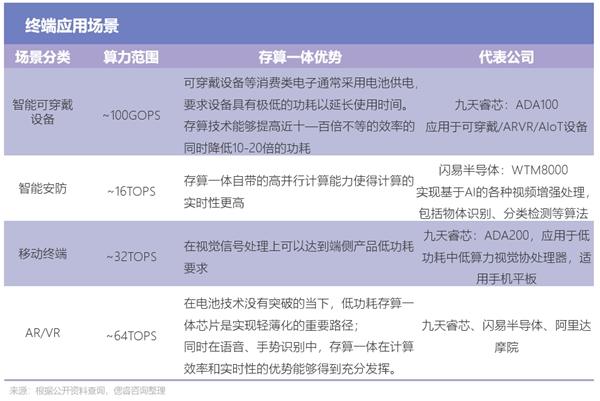

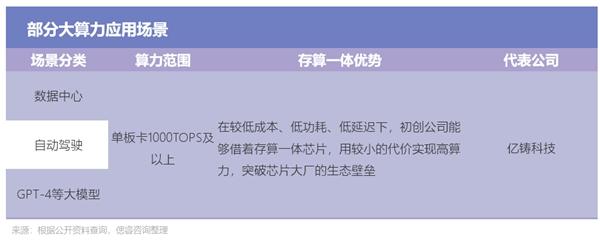

由上面两张图可以看到,仅有选择新型存储器RRAM的公司,能够实现大算力,而其余基于传统存储器的基本仅能cover住AIOT、车载模块等低算力场景。

例如亿铸科技,基于RRAM研发“全数字存算一体”大算力芯片,通过减少数据搬运提高能效比,同时利用数字存算一体保证运算精度,能够应用于云端AI推理、边缘计算、数据中心、自动驾驶等大算力场景。

03从2MB的AIOT到512MB的自动驾驶

从上文公司产品应用场景可以看出,存算一体应用广泛,既能装在一块小小的智能门锁,也能应用于1000+TOPS的数据中心。那么,存算一体到底能cover住多少场景?

综合市面上已有的报告以及专家观点,祁6床旖τ贸【鞍凑账懔Υ笮〗谢:

一是端侧小算力场景,例如智能可穿戴设备、智能安防、移动终端、AR\VR等。

二是大算力场景,例如云计算数据中心、自动驾驶、GPT-4等大模型等。

目前,业内对于大算力的“大”界定是模糊的,而根据下游市场的实际需求,大算力起码是1000TOPS及以上:

以2020年发布的GPT3预训练语言模型为例,采用的是2020年最先进的英伟达A100 GPU,算力是624 TOPS。2023年,随着模型预训练阶段模型迭代,又新增访问阶段井喷的需求,未来模型对于芯片算力的需求起码要破千。

再例如自动驾驶领域,根据财通证券(601108,诊股)研究所表明,自动驾驶所需单个芯片的算力未来起码1000+TOPS。目前巨头已开始卷上1000+TOPS的SoC,主要用于自动驾驶领域:在2021年4月,英伟达就已经发布了算力为1000TOPS的DRIVE Atlan芯片。到了今年,英伟达直接推出芯片Thor达到2000TOPS。

目前来看,在存算一体架构下,能够真正实现大算力的,仅有亿铸科技一家:

而在这两大类场景之中,存算一体并非都有着绝对性的优势。针对端侧的可穿戴等小设备,由于AI加速能力占比过小,存算一体的优势并不大:ARM占30%,降噪或ISP占40%,AI加速能力仅占30%。

但云和边缘大算力场景,是存算一体芯片的优势领域。这是因为,大算力场景下,对设备提出了高要求:实现高性能、高计算密度、高算力的同时还需实现低功耗。而这,就大部分仰仗于AI能力。据业内人士表示,存算一体在云和边缘的大算力领域的竞争力影响约占90%。

04未来的路:“第三极”、融合、突破天花板

存算一体正博得学界、产界等各路人马的青睐,基于现有的技术、发展路径以及应用场景并结合业内人士观点,祁6床烊衔嫠阋惶褰凶乓韵路⒄骨魇:

1、随着AI技术的加速落地,ChatGPT等大模型对算力的大量需求,将为存算一体技术带来核级推动力。存算一体将成为继CPU、GPU架构之后的算力架构“第三极”。

2、在布局存算一体的玩家之中,有创新精神、强劲研发、工程实力的团队及公司将脱颖而出。

这是因为,存算一体芯片在设计层面有较高难度,且没有成熟的方法可供参考:存算一体是计算系统和存储系统的整合设计,比标准模拟IP和存储器IP更复杂,依赖于多次存储器流片而积累的经验,这就需要创始团队有充分的存储器量产经验和技术路线认知。

根据量子位针对存算一体公司多位高管的多次采访,综合来看,团队需具备以下能力:

1)领导层要有清晰的目标:在存储器和计算模式、架构的选择上要有清晰的思路,并且能够准确、快速地带领团队往前走。

2)团队需具有深厚技术背景的人员,对技术方向有精准把握,尤其是在新型存储器技术上的探索。

3)在核心研发、工程团队中,需要在技术的各个层级中配备经验丰富的人才。

3、与多种先进技术融合,实现系统级创新,从而突破算力天花板。

在ISSCC 2023,苏妈提出系统级创新概念,即从整体设计的上下游多个环节协同设计来完成芯片性能的提升,并给出使用该概念实现数量级的效率提升案例。

也就是说,若是将存算一体、Chiplet(芯粒)、3D封装等技术同步使用,很有可能带来数量级的效率提升,从而突破性能瓶颈。

目前,国内已有团队进行“系统级创新”实践:作为首发存算一体超异构概念的亿铸科技,提出了自己的技术畅想:

若能把新型忆阻器技术(RRAM)、存算一体架构、芯粒技术(Chiplet)、3D封装等技术结合,将会实现更大的有效算力、放置更多的参数、实现更高的能效比、更好的软件兼容性、从而抬高AI大算力芯片的发展天花板。

乐酷家生活网(lekujia.com)—生活消费—快乐生活多一点点,炫酷生活就在乐酷家生活网